Kunstig intelligens kan gi betydelig verdi. Dessverre ser vi at mange undervurderer det viktigste. Nemlig å bygge en solid grunnmur.

Intelligensrevolusjonen er i gang, og kan gi inntrykk av at man er dømt til undergang, hvis man ikke allerede surfer på bølgen. For de fleste er det neppe så dramatisk, men kunstig intelligens begynner å bli et tilgjengelig fagfelt med et hav av muligheter. Vi ser stadig at disse konkrete punktene undervurderes i AI-prosjekter.

Definer et konkret formål for roboten

Det aller viktigste steget er å klart definere formålet med roboten, da dette setter klare rammer for hele AI-prosjektet Dette inkluderer en problemstilling roboten skal løse og hvilken verdi den er tenkt å tilføre. Eksempelvis kan en bank få mange gjentagende spørsmål på epost eller chat om hvordan kundene kan finne sin boliglånsrente eller hvordan de kan sette opp BankID på mobil. Å besvare slike enkle, gjentagende spørsmål tar tid fra kunderådgivernes mer komplekse oppgaver og en epost eller chatrobot vil relativt enkelt kunne besvare denne typen henvendelser.

Bruk data med riktig struktur og kvalitet

All kunstig intelligens understøttes av en mengde data som er valgt ut for å «lære» roboten hvordan den skal handle i forskjellige situasjoner. Dersom den ovennevnte banken skal kunne implementere sin chatrobot, trenger de data fra reelle kundeinteraksjoner. Dersom banken ikke har disse dataene tilgjengelig i dag, må de sette i gang en prosess for datafangst. Når dataene er tilgjengelige, må de vaskes og struktureres for analyse. Dette er ofte en tidkrevende prosess fordi dataene fra produksjonssystemene ikke er strukturert for analyse ut av boksen og de ofte inneholder en del støy. Når dataene er vasket og strukturert, er det viktig å undersøke hvorvidt dataene er egnet til formålet som skal oppnås; dette er en prosess som krever en del prøving og feiling.

En AI er kun så god som dataene den er bygget på.

I denne testfasen velger man gjerne ut et lite subsett av problemene chatboten er tenkt å løse og forsøker ved hjelp av domenespesialister å finne et fungerende datasett. Her kan man gjerne bruke enkle, statiske datadumper hentet fra produksjonssystemene til innledende testing. Man bør også gjøre vurderinger av datakvaliteten. Det viser seg ofte at data inneholder mange feil og mangler, til tross for at de hentes direkte fra produksjonssystemene. Problemene med datakvalitet kan være forårsaket eksempelvis av at enkelte av dataene man gjerne skulle hatt ikke finnes i produksjonssystemet, klønete dataformater fra produksjonssystemet eller feil gjort av mennesker ved bruk av produksjonssystemet. Dersom datakvaliteten er svak, må man se seg om etter et annet passende datasett, en annen modelleringsmetode eller skrote prosjektet.

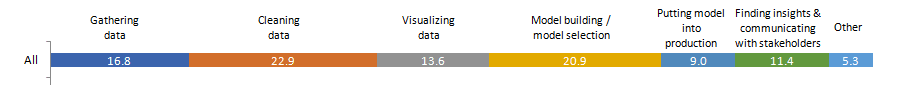

50 % av tiden i et data science-team brukes på “usynlige” oppgaver

Hva skiller virksomheter med høy modenhet innen dataanalyse?

Det er viktig å huske på at denne fasen ofte er lang og preges av prøving og feiling. I et typisk data science-team brukes rundt 17 % av tiden på datainnsamling og nesten en fjerdedel av tiden på vasking og strukturering av data. Dersom man regner visualisering av data, ofte brukt i innledende undersøkelser for å vurdere bl.a. datakvalitet, som en «usynlig» oppgave som skjer back-end, bruker teamet over halvparten av sin tid på oppgaver mange utenfor teamene glemmer at må gjøres for at prosjektet skal bli vellykket.

Ha en realistisk tidslinje

Ved igangsetting av slike prosjekter er det viktig å kjenne til de nevnte prosessene og at de er tidkrevende slik at man kan lage en realistisk tidslinje og sette sammen et team med riktig kompetanse. Det vil være mulig å lage raske løsninger, men i mange tilfeller vil kvaliteten på løsningen lide. I et chatbot-prosjekt vil dette selvsagt påvirke kundeopplevelsen i tillegg; vi har alle snakket med en chatbot som ikke forstår noe av det vi spør om.